[解決済み】オンラインファイル/フォルダーリストに表示されているすべてのファイルとサブディレクトリを含むHTTPディレクトリをダウンロードする方法は?

2022-05-11 02:18:38

質問

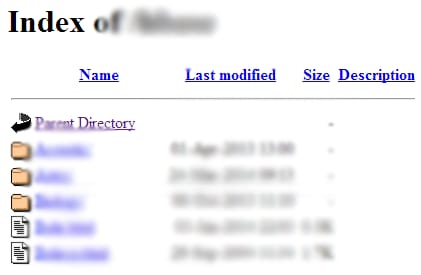

私がアクセスできるオンラインHTTPディレクトリがあります。私はすべてのサブディレクトリとファイルをダウンロードしようとしました

wget

. しかし、問題なのは

wget

はサブディレクトリをダウンロードします。

index.html

ファイルをダウンロードすることなく、そのディレクトリにあるファイルのリストを含むファイルをダウンロードします。

深さ制限なしでサブディレクトリとファイルをダウンロードする方法はありますか(ダウンロードしたいディレクトリがちょうど私のコンピュータにコピーしたいフォルダであるかのように)。

解決方法は?

解決方法

wget -r -np -nH --cut-dirs=3 -R index.html http://hostname/aaa/bbb/ccc/ddd/

説明する。

- にあるすべてのファイルとサブフォルダをダウンロードします。 ddd ディレクトリ

-

-r: 再帰的に -

-np: のように上位ディレクトリに行かない。 ccc/... -

-nH: hostname フォルダにファイルが保存されない -

--cut-dirs=3: に保存していますが ぽっちゃり 省みず 最初の3つのフォルダー なんちゃって , 玉石混交 , シーシー -

-R index.htmlを除く。 索引.html ファイル

関連

-

[解決済み】このインラインブロックのdiv要素の間に説明のつかない隙間があるのはなぜですか?[重複]

-

[解決済み】divの高さを画面の残りスペースで埋めるようにする

-

[解決済み] type="application/x-shockwave-flash "で表示可能な形式は?

-

[解決済み] Androidでファイルをダウンロードし、ProgressDialogで進捗を表示する。

-

[解決済み] wgetでダウンロード先を指定するには?

-

[解決済み] スクリプトタグ - 非同期と遅延

-

[解決済み] wget を使って任意のファイルを含むディレクトリを再帰的に取得する

-

[解決済み] Googleドライブから大きなファイルをwget/curlする

-

[解決済み] URLからサーバーにファイルをダウンロードする

-

[解決済み] wgetを使用してディレクトリ全体とサブディレクトリをダウンロードする方法は?

最新

-

nginxです。[emerg] 0.0.0.0:80 への bind() に失敗しました (98: アドレスは既に使用中です)

-

htmlページでギリシャ文字を使うには

-

ピュアhtml+cssでの要素読み込み効果

-

純粋なhtml + cssで五輪を実現するサンプルコード

-

ナビゲーションバー・ドロップダウンメニューのHTML+CSSサンプルコード

-

タイピング効果を実現するピュアhtml+css

-

htmlの選択ボックスのプレースホルダー作成に関する質問

-

html css3 伸縮しない 画像表示効果

-

トップナビゲーションバーメニュー作成用HTML+CSS

-

html+css 実装 サイバーパンク風ボタン

おすすめ

-

[解決済み】CSSの背景画像が表示されない。

-

[解決済み] 名前が''の無効なフォームコントロールはフォーカスされない

-

[解決済み】Markdownで'target="_blank"'でリンクを作成することはできますか?

-

[解決済み] ボディの背景色が表示されない?

-

[解決済み] CSS - display: none; が機能しない

-

[解決済み] <html xmlns="http://www.w3.org/1999/xhtml">」は何をするのですか?

-

[解決済み] 背景画像を前後にパンするCSS【非公開

-

[解決済み] Angular 2+のテンプレートで値を表す三項演算子

-

[解決済み] 電話番号のマークアップはどのように行うのですか?

-

[解決済み] 画像をインラインで表示する方法